數據湖存儲格式Hudi 核心原理與數據處理實踐

引言

在大數據時代,數據湖已成為企業整合和分析海量多源異構數據的關鍵基礎設施。傳統數據湖在支持實時更新、增量處理和數據治理方面面臨挑戰。Apache Hudi(Hadoop Upserts Deletes and Incrementals)應運而生,作為一種開源數據湖存儲格式,它通過在Hadoop兼容的存儲上引入事務、更新、刪除和增量處理等核心能力,極大地提升了數據湖的實時性與可管理性。本文將深入探討Hudi的核心原理,并結合實際場景,闡述其在數據處理與存儲服務中的最佳實踐。

一、Hudi的核心設計原理

Hudi的核心目標是高效地管理大型分析數據集,支持記錄級的插入、更新和刪除(即Upsert/Delete操作),同時提供快速的增量查詢能力。其設計圍繞兩個核心概念展開:表類型和查詢類型。

- 表類型(Table Types)

- Copy-On-Write(COW)表:此類型在寫入時直接重寫整個數據文件。當執行更新操作時,Hudi會找到包含該記錄的文件,用包含更新后記錄的新文件替換原文件,同時保留其他未更改的記錄。這種方式讀取性能最優,因為數據始終以列式格式(如Parquet)存儲,但寫入延遲較高,適合讀多寫少的場景。

- Merge-On-Read(MOR)表:此類型將更新數據寫入到增量日志文件(通常是Avro格式),而基礎數據文件(Parquet格式)保持不變。在讀取時,Hudi會動態合并基礎文件和增量日志,以提供最新的數據視圖。這種方式寫入延遲低,支持更快的Upsert,但讀取時需要額外的合并開銷,適合寫多讀少或需要近實時數據攝入的場景。

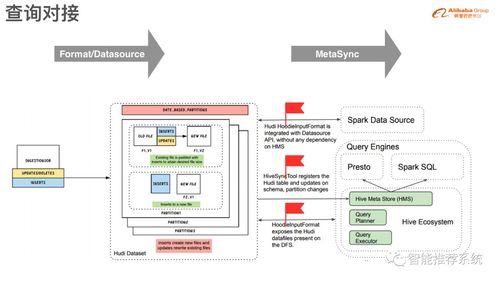

- 查詢類型(Query Types)

- 快照查詢(Snapshot Query):查詢給定提交或壓縮操作后表的最新快照。對于MOR表,它會即時合并基礎文件和增量日志;對于COW表,則直接讀取最新的數據文件。

- 增量查詢(Incremental Query):查詢自某個指定提交以來新增或更改的數據。這是Hudi的核心優勢之一,能夠高效地向下游系統(如ETL管道、流處理作業或數據倉庫)提供增量數據流,無需全表掃描。

- 讀優化查詢(Read Optimized Query):僅查詢MOR表中已壓縮成列式格式的基礎數據文件,提供最佳的讀取性能,但數據可能不是最新的(存在延遲)。

Hudi通過其獨特的時間軸(Timeline) 機制來管理所有對數據集的操作(提交、壓縮、清理)。時間軸存儲在.hoodie元數據目錄下,記錄了每次操作的時間戳、狀態和類型,為事務一致性、數據版本控制和增量拉取提供了基礎。

二、Hudi在數據處理與存儲服務中的實踐

將Hudi集成到數據處理流水線中,可以顯著提升數據管理的靈活性和效率。以下是幾個關鍵實踐場景:

- 近實時數據攝入與更新

- 場景:來自Kafka、數據庫CDC(變更數據捕獲)流的實時數據需要被持續寫入數據湖,并支持對歷史記錄的更新。

- 實踐:使用Hudi的DeltaStreamer工具或直接使用Spark/Flink的Hudi連接器,將流數據以Upsert模式寫入MOR表。通過設置合理的壓縮調度(將增量日志合并到基礎文件),可以在寫入性能和讀取效率之間取得平衡。這避免了傳統上需要周期性重寫整個分區的開銷。

- 構建高效的增量ETL管道

- 場景:下游的聚合計算、指標分析或數據同步任務只需要處理自上次運行以來變化的數據。

- 實踐:利用Hudi的增量查詢功能。任務可以記錄上一次成功處理的提交時間點,下次運行時通過Hudi的增量查詢API,只拉取該時間點之后變更的數據(包括插入、更新和刪除),極大地減少了數據處理量,提升了管道效率,并實現了準實時的數據新鮮度。

- 數據治理與生命周期管理

- 場景:需要遵守數據保留策略、刪除特定用戶數據以符合GDPR等法規,或清理過期數據。

- 實踐:Hudi支持記錄級的刪除操作(軟刪除和硬刪除)。通過簡單的刪除操作,并結合其內置的

clean服務(自動清理舊版本的文件和不再需要的增量日志),可以方便地管理數據生命周期,保持存儲空間的高效利用,同時確保數據的合規性。

- 統一批流存儲與服務層

- 場景:希望用同一套存儲同時服務批處理作業(如每日報表)和交互式/流式查詢(如實時儀表盤)。

- 實踐:Hudi表天然支持這一需求。批處理作業可以使用快照或讀優化查詢獲取一致性視圖;流式查詢或交互式分析引擎(如Presto/Trino, Spark SQL)則可以通過快照查詢訪問最新數據。Hudi與這些查詢引擎深度集成,提供了開箱即用的高性能連接。

三、最佳實踐與注意事項

- 鍵的設計:合理選擇記錄鍵(

recordKey)和分區路徑(partitionPath)至關重要。記錄鍵用于唯一標識和更新記錄,分區路徑則決定了數據的物理組織方式,影響查詢過濾效率。 - 文件大小管理:配置合適的目標文件大小,避免產生過多小文件(影響查詢性能)或過大的文件(影響寫入和壓縮效率)。利用Hudi的自動文件大小管理功能。

- 壓縮與清理策略:針對MOR表,根據業務對數據新鮮度和查詢性能的要求,設定合理的異步壓縮策略。配置清理策略以刪除舊的文件版本,控制存儲成本。

- 索引選擇:Hudi提供了多種索引(如布隆過濾器索引、全局索引等)來快速定位記錄所在文件。根據數據分布和查詢模式選擇合適的索引類型,以優化Upsert性能。

結論

Apache Hudi通過創新的存儲格式和表管理機制,將數據庫的事務性、更新刪除能力與數據湖的可擴展性、成本效益相結合。它不僅僅是存儲格式,更是一套完整的數據湖管理與服務解決方案。深入理解其COW/MOR表類型和快照/增量查詢模型,并結合實際業務場景進行合理設計與調優,能夠構建出更加實時、高效和易于治理的數據湖,從而最大化數據資產的價值,賦能企業的數據分析與決策。

如若轉載,請注明出處:http://www.finance2.cn/product/57.html

更新時間:2026-01-19 10:32:00