自然語言處理與對話技術研究進展及個人思考

自然語言處理(NLP)作為人工智能領域的重要分支,近年來在人機對話技術驅動下取得顯著進展。本文結合個人研究經驗,探討NLP技術的演進脈絡、現狀挑戰與未來方向,并分享在數據處理與存儲服務方面的實踐思考。

一、自然語言處理技術發展脈絡

自然語言處理技術經歷了從規則驅動到統計建模,再到深度學習的三次范式變遷。早期基于詞典和語法規則的符號主義方法受限于語言復雜性,難以處理歧義與多樣性。21世紀初統計學習方法興起,通過隱馬爾可夫模型、條件隨機場等算法顯著提升了詞性標注、命名實體識別等任務的性能。2013年后,以Word2Vec為代表的詞向量技術將語義信息編碼為稠密向量,為深度學習方法奠定基礎。2018年BERT模型突破性采用Transformer架構與預訓練-微調范式,在GLUE等基準測試中刷新多項記錄,標志著NLP進入預訓練大模型時代。

二、人機對話技術的關鍵突破

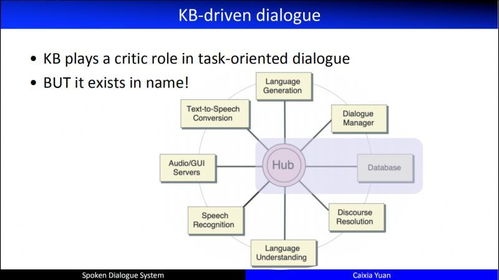

人機對話系統可分為任務導向型與開放域對話兩大類別。任務型對話通過意圖識別、槽位填充等技術實現精準服務,已在客服、智能家居等場景規模化落地。開放域對話則更注重語義理解與生成質量,GPT系列模型通過自回歸生成實現了上下文連貫的多輪對話。值得關注的技術進展包括:

- 跨模態對話融合視覺、語音等多模態信息

- 知識增強對話通過外部知識庫提升回答準確性

- 情感感知技術使對話系統能識別用戶情緒并調整響應策略

- 持續學習機制讓系統在使用過程中不斷優化對話能力

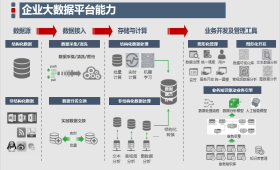

三、數據處理與存儲的技術實踐

高質量數據是NLP模型的基石。在數據采集階段需注重:

- 多源數據融合:整合結構化與非結構化數據

- 數據標注策略:結合主動學習與眾包標注提升效率

- 隱私保護機制:采用差分隱私、聯邦學習等技術

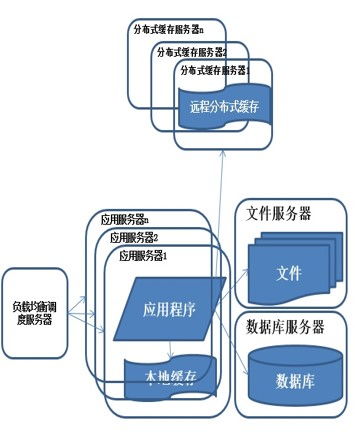

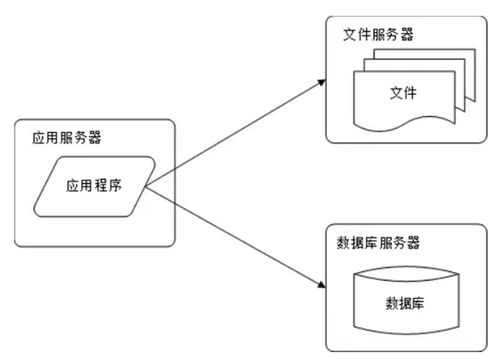

數據存儲層面,建議采用分層存儲架構:

- 熱數據使用內存數據庫支撐實時對話

- 溫數據通過分布式文件系統存儲訓練樣本

- 冷數據歸檔至對象存儲降低成本

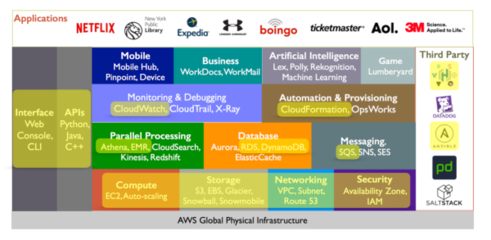

在SegmentFault等技術社區實踐中,我們構建了基于Elasticsearch的語義檢索系統,支持千萬級技術文檔的智能問答,通過向量化存儲實現毫秒級相似度匹配。

四、挑戰與未來展望

當前技術仍面臨諸多挑戰:

1. 少樣本學習:如何降低對標注數據的依賴

2. 可解釋性:增強模型決策過程的透明度

3. 倫理對齊:避免生成有害內容與偏見放大

4. 能耗優化:降低大模型訓練與推理的資源消耗

未來發展方向可能集中于:

- 構建具身智能實現與現實世界的交互理解

- 發展因果推理能力超越相關性學習

- 探索神經符號融合的新范式

- 推動輕量化模型在邊緣設備的部署

自然語言處理正從感知智能邁向認知智能,人機對話技術將深度重塑人機交互范式。作為研究者,我們既要擁抱技術革新,也需保持對技術倫理的審慎思考,在數據處理、模型研發與應用落地間尋求平衡,最終構建真正理解人類意圖的智能對話系統。

如若轉載,請注明出處:http://www.finance2.cn/product/28.html

更新時間:2026-01-19 22:19:43